هنرمندان و عکاسان حرفهای که از شرکتهای هوش مصنوعی تولیدکننده برای استفاده از آثار خود برای آموزش فناوری خود ناراحت هستند، ممکن است به زودی راهی موثر برای پاسخگویی داشته باشند که نیازی به مراجعه به دادگاهها نداشته باشد.

هوش مصنوعی تولیدکننده تقریباً یک سال پیش با راه اندازی چت بات ChatGPT وارد صحنه شد. این ابزار در برقراری مکالمه به روشی بسیار طبیعی و شبیه انسان بسیار ماهر است؛ اما برای به دست آوردن این توانایی، باید با انبوهی از دادههای جمع آوری شده از اینترنت آموزش داده شود.

ابزارهای هوش مصنوعی تولیدکننده مشابه نیز قادر به تولید تصاویر از متون هستند، اما مانند ChatGPT، آنها با جمع آوری تصاویر منتشر شده در اینترنت آموزش میبینند.

این بدان معناست که هنرمندان و عکاسان آثار خود را بدون رضایت یا جبران خسارت توسط شرکتهای فناوری برای ساخت ابزارهای هوش مصنوعی تولیدکننده خود استفاده میکنند.

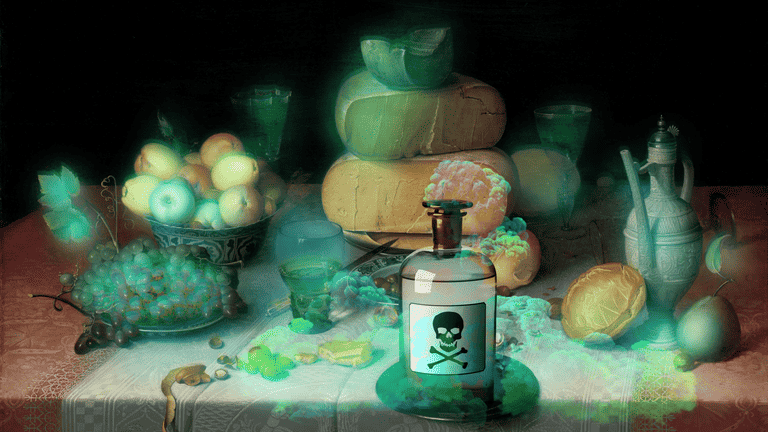

برای مبارزه با این موضوع، تیمی از محققان ابزاری به نام Nightshade را توسعه دادهاند که قادر به گیج کردن مدل آموزشی است و باعث میشود در پاسخ به درخواستها، تصاویر اشتباهی را تولید کند.

Nightshade که اخیراً در مقالهای توسط MIT Technology Review شرح داده شده است، با افزودن پیکسلهای نامرئی به یک اثر هنری قبل از آپلود آن در وب، دادههای آموزشی را «مسموم» میکند.

گزارش MIT میگوید: «استفاده از آن برای مسموم کردن این دادههای آموزشی میتواند به تکرارهای آینده مدلهای هوش مصنوعی تولیدکننده تصویر، مانند DALL-E، Midjourney و Stable Diffusion آسیب برساند، زیرا برخی از خروجیهای آنها را بیفایده میکند – سگها به گربه تبدیل میشوند، ماشینها به گاو تبدیل میشوند و غیره.» و افزود که تحقیقات پشت Nightshade برای بررسی همتایان ارسال شده است.

در حالی که ابزارهای تولید کننده تصویر چشمگیر هستند و به طور مداوم در حال بهبود هستند، نحوه آموزش آنها بحث برانگیز بوده است. بسیاری از سازندگان این ابزارها در حال حاضر با شکایات هنرمندانی که ادعا میکنند آثارشان بدون اجازه یا پرداخت استفاده شده، مواجه هستند.

بن ژائو، استاد دانشگاه شیکاگو و رهبر تیم تحقیقاتی پشت Nightshade، گفت که چنین ابزاری میتواند به بازگرداندن تعادل قدرت به هنرمندان کمک کند و یک اخطار به شرکتهای فناوری که حق چاپ و مالکیت معنوی را نادیده میگیرند، بدهد.

MIT Technology Review در گزارش خود گفت: «مجموعه دادهها برای مدلهای هوش مصنوعی بزرگ میتوانند از میلیاردها تصویر تشکیل شوند، بنابراین هرچه تصاویر مسموم بیشتری بتوانند در مدل جمعآوری شوند، این تکنیک آسیب بیشتری وارد میکند.»

این تیم قصد دارد پس از انتشار Nightshade، آن را متن باز کند تا دیگران بتوانند آن را پالایش کنند و موثرتر کنند.

تیم پشت Nightshade با آگاهی از پتانسیل آن برای ایجاد اختلال، گفت که باید از آن به عنوان آخرین دفاع برای سازندگان محتوا در برابر وب اسکریپتهایی که حقوق آنها را نادیده میگیرند، استفاده شود.

در تلاش برای رسیدگی به این موضوع، سازنده DALL-E، OpenAI، اخیراً به هنرمندان اجازه داده است آثار خود را از دادههای آموزشی خود حذف کنند. اما این فرآیند بسیار سنگین توصیف شده است؛ زیرا نیاز دارد که هنرمند یک نسخه از هر تصویری را که می خواهد حذف کند، همراه با توضیحات آن تصویر، به طوری که هر درخواست نیاز به درخواست جداگانه دارد، ارسال نماید.

آسانتر کردن روند حذف ممکن است تا حدودی از تمایل هنرمندان به استفاده از ابزاری مانند Nightshade جلوگیری کند، که میتواند در درازمدت مشکلات بیشتری برای OpenAI و دیگران ایجاد کند.

منبع: Digitaltrends

نظرات